2023年,以ChatGPT为首的生成式人工智能以迅雷不及掩耳之势,引爆了全球人工智能产业的浪潮。无数的初创企业和各行各业龙头将目光投向了大模型研发和AI应用领域。

作为AI芯片行业的知名企业英伟达,在近日也推出了一款聊天机器人——Chat With RTX,基于人工智能公司的两款开源语言大模型,即Mistral和Llama 2。AI芯片原本是大模型运行的动力源泉,作为AI芯片制造商的英伟达开始自研聊天机器人,从幕后转到台前,这一举动是为什么?

据悉OpenAI CEO山姆·奥特曼正在计划筹集7万亿美元重塑全球半导体行业,要知道2023年芯片制造设备市场的投资金额也才1千亿美元,美国两家最大的上市公司微软和苹果的市值相加刚刚超过6万亿美元。强烈对比之下,可见奥特曼对AI芯片自研自用投入的巨大期待和心血。

其实奥特曼长期以来一直在谈论人工智能芯片的供需问题,对于目前的科技公司来说,要想在大模型的竞争中赶上潮流,就必须构建强大的算力设施,昂贵且短缺的AI芯片正在成为瓶颈,而且已经一定程度上限制了OpenAI的成长。对于初创企业而言,无法通Open AI这样具有强大融资能力的公司相比,通过自研芯片以提供大模型运行所需的高质量算力,就可以通过寻求算力租赁或显卡租用平台来获取大模型运行必备的算力基础设施,例如备受好评的算力云平台,近日算力云平台还推出全平台显卡包括在大模型运行领域备受推荐的A100/V100/TESLA T4/RTX 4090的显卡,均可享受春节特惠活动,全平台75折优惠,至本月底结束。

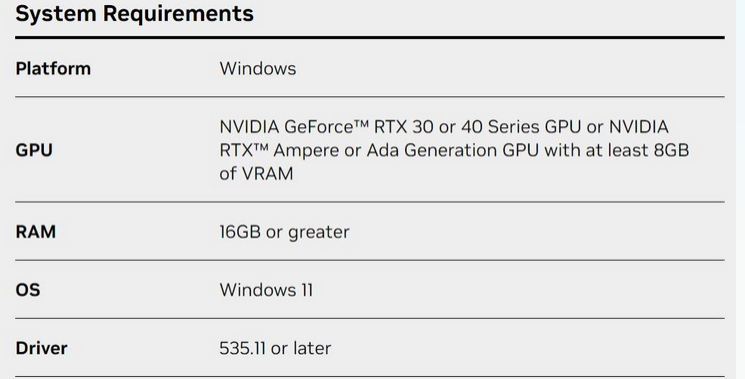

在大模型行业领先者Open AI对芯片领域虎视眈眈的情况下,AI芯片行业的先锋者英伟达居安思危,用行动回应此举,开始布局大模型领域,推出了旗下的第一款聊天机器人——Chat With RTX,据悉该聊天机器人并非是在网页或APP中运行,而是需要下载安装到个人电脑中。对于电脑配置要求也有较高的要求,例如至少配备8GB显存的RTX 30或40系列显卡才能支持该应用程序,许多不满足此要求的用户可以通过显卡租用的方式,例如在算力云平台租用RTX3080/4090的显卡来使用该聊天机器人。

与市场上主流的聊天机器人不同的是,Chat With RTX无需联网,在本地运行。在Chat With RTX中上传本地文件后,就可以基于文件中的内容和它进行对话。这意味着它在聊天内容上没有那么多的限制,并且可以以更快地速度对话。

更值得一提的是,Chat with RTX 在扫描PDF 文件和核对数据时非常有用。微软自己的 Copilot 系统在 Word 中不能很好地处理 PDF 文件,但 Chat with RTX 聊天系统可以毫无问题地提取出所有关键信息,回复也近乎即时,没有通常使用基于云的 ChatGPT 或 Copilot 聊天机器人时的延迟。

但是作为新出茅庐的聊天机器人,Chat With RTX依然有很多不足,例如它更擅长查找,不擅长推理。对此英伟达承认,在Chat with RTX中询问几份文档中涉及的事实可能比询问一份文档或一组文档的摘要要得到更好的结果。

还有一个比较大的缺点是,它不能记忆上下文。比如,你问“北美常见的鸟类是什么?”,然后接着问“它是什么颜色?”,它就不知道你是在问鸟的颜色,而目前市场上大多数聊天机器人已经具有该功能。

写在最后

在这个算力至上的时代,AI芯片逐渐成为紧缺的资源,科技公司若想突破困境,采用软硬结合的方式布局AI市场,长远来看将是一次伟大的尝试。